|

diffusion--扩散 1.原图片(信息清晰,集中,内容可识别性强)

2.扩散(增加噪声,就是让他变得模糊)

3.生成(去除声噪)AI深度学习扩散的“逆过程”,从而领会了生成特定内容的方式 AI深度学习:拿图片给AI学习的过程叫喂图,喂成功的AI叫XXX模型,不同模型有不同的画风,拿二次元画风喂出来的绝对产出3D风格的图片,所以要根据需求选择模型。 models

模型+提示词+参数=内容

Checkpoint:检查点

1.训练模型是一个耗时的过程。Checkpoint允许用户在训练过程中的特定时刻保存模型的状态,以便在需要时能够恢复并继续训练,从而节省时间和资源

总结:数据回滚与模型后期的更新迭代

2.通过对Checkpoint进行微调,可以实现对不同画风和技巧的偏重,从而创建出具有特定风格的AI绘画模型

总结:对接提示词的接口

3.在AI绘画中,有大量的Checkpoint模型可供选择。用户可以根据自己的需求,选择适合的Checkpoint模型进行加载和使用,以便快速生成符合期望的绘画作品

总结:换不同画风的AI模型用的

1.seed:随机种子

模型每生成一个图片都会给图片一个随机种子相当于该图片的唯一标识符(ID),如果我们想对图片比较满意想在此图片的基础上继续修改,就要给模型此图片的随机种子让模型知道你想要修改的是那张图片。

有4个选项fixed(种子固定),increment,decrement,randomize(种子随机)

2.steps(步数(采样迭代步数)):把图片扩散到生成一个新图片的过程,20步就是20张图片从一个模糊图片到清晰图片过程(步数)

3.CFG(提示词相关性):值越大和提示词与符合,值越小AI发挥空间大,不是越大越好10左右就ok

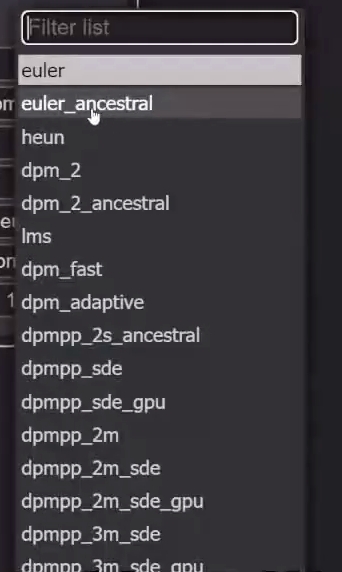

4.sampler_name:采样器:负责控制去噪的具体操作

选择项:

euler_ancestral,dpm_2 ancestral,dpm_adaptive,dpmpp_2m_sde

,dpmpp_2m_sde_gpu,dpmpp_3m_sde 后缀带_a和_sde随机性会更强

dpm_ fast :早期的采样方法(一般不用) dpmpp_改良版 :二者之间 dpm_2是迭代版:质量高,生成时间长,生成速度是dpm的2倍 euler,heun较早期的采样方法 5.scheduler调度程序:负责调控去噪的程度,决定每一步去除多少噪声,确保整个过程高效与精准在每一步控制噪声量的一个大小

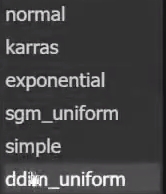

选择项:

normal: 一个线性的指数,开始给一个很大的噪声量在逐渐减少(标准的)

karras:一个S形的指数,先小在大,在小(平滑的)

exponential:断崖式的

sgm_uniform:一般不用

simple:简单快速的,作者写的玩的,不用

ddim_uniform:一般不用

6.denoise噪点:在K采样器中步数是按多少百分比完成。比如噪点值是1,按照100%的步数完成上图是20步完成,那就按照20步完成,如果噪点值是0.5,按上图的20步数就是10步完成,在文生图中就用1不动。

|  打卡薪网课程

2136 人阅读

|

0 人回复

打卡薪网课程

2136 人阅读

|

0 人回复