|

大家好,我是叶子,今天红楼大佬课程上完,小打卡一下,第一次写日记,有什么不足欢迎大家补充。

首先ai代写第一步就大概了解如何使用ai进行写作的流程,具体可看红楼大佬https://bbs.qianyechuangxin.com/ ... thread&tid=1786,陈bu懂大佬的帖子https://bbs.qianyechuangxin.com/ ... thread&tid=1894

其次新手建议先淘宝接单,具体看Q师傅的帖子https://bbs.qianyechuangxin.com/ ... thread&tid=2072,需要注意的点就是询问客服招写手时候一般都需要帮他们刷个单(会退你钱),然后才能拉你进群。一开始我还不懂,还以为骗我刷单,然后傻呼呼不理,后面加了Q师傅询问才知道,这些都正常。

后面就是正常在群里抢单子了,建议遇到简单可以直接接,因为刚开始经常犹犹豫豫,然后错过了单子。下面我给大家入门一下完成一个简单的小单子过程:

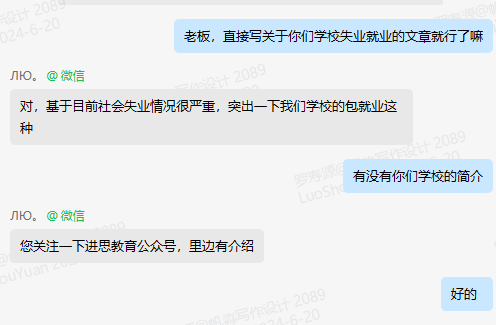

客户需求:

大概就是帮写一篇内容营销的引流文章,学校叫北京进思学校,包就业分配,基于目前社会失业情况很严重,突出一下学校的包就业,400-500字左右

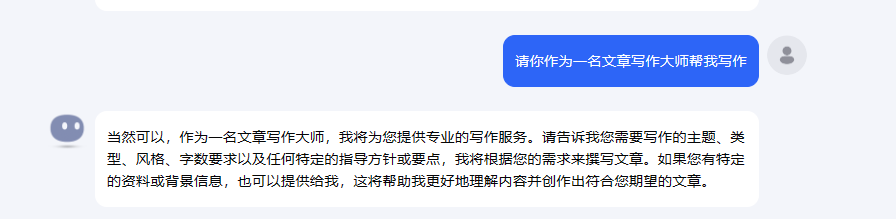

新手刚开始使用ai的时候的可以先少使用prompt(就是模板),直接给让ai代入角色,然后提出任务需求

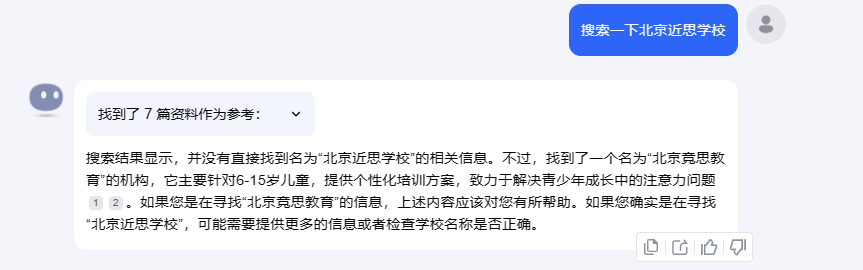

当时我先搜索一下他们学校的内容:

然后没啥用,搜不出来,哈哈哈哈,然后大概去他们公众号了解了一下,大概就是计算机的培训机构。

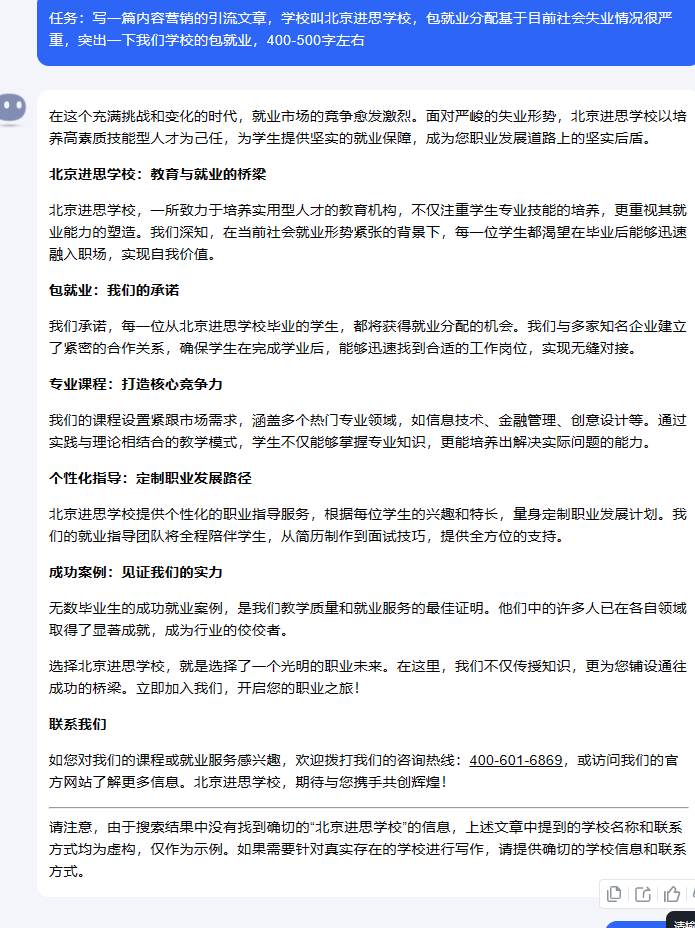

接着我直接不管了,代入需求:

也是很轻松就完成了这个篇文章的大概书写 接着起个文章标题

然后复制到文档里,大概修改一下格式和内容就好。 后面客户还有一些建议

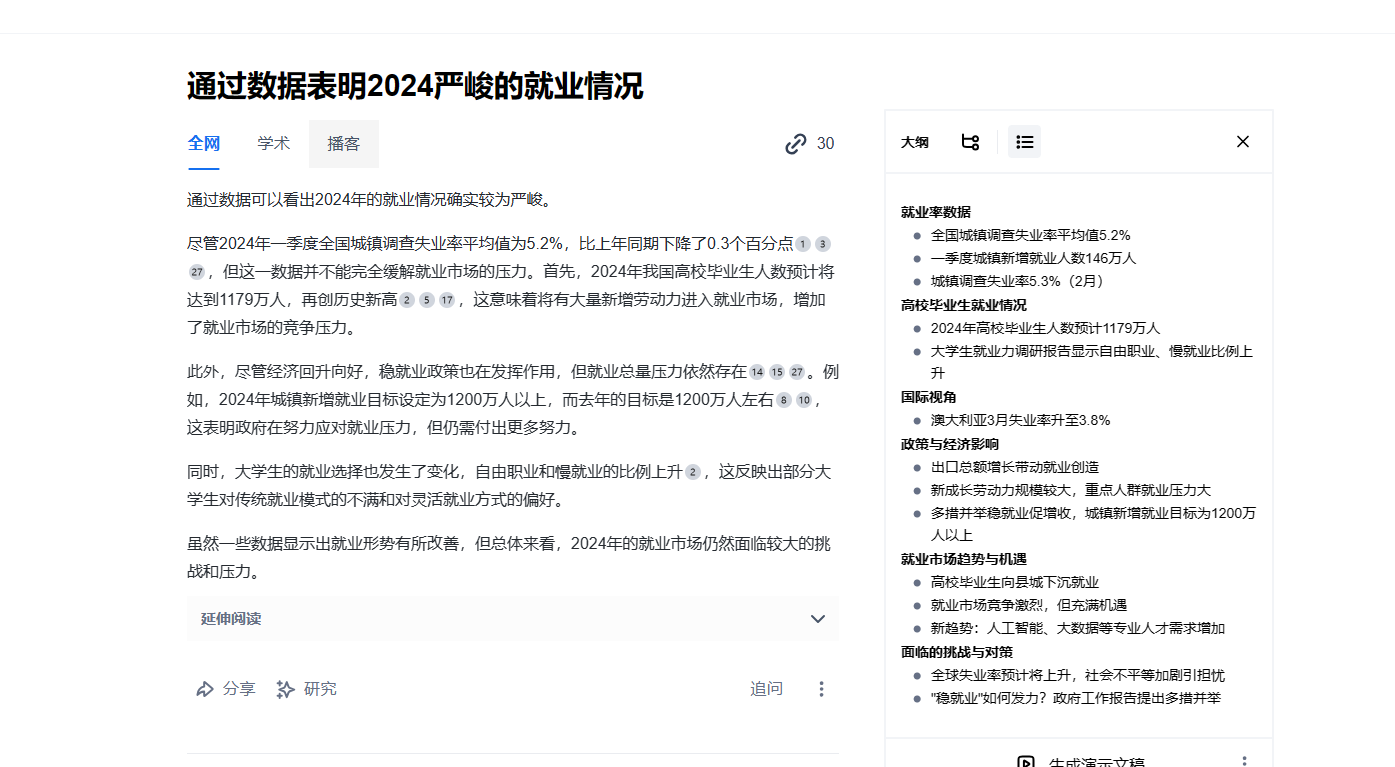

接下来就是根据客户需求修改一下 先利用秘塔AIhttps://metaso.cn/搜一下当前就业环境

然后把觉得相对应的信息复制到文档然后向ai提出结合相关数据就好了。

后面就是复制粘贴轻松完成任务QAQ

第一篇日记,写的不好的地方欢迎指出,也欢迎大家相互讨论。本篇还是相对简单理解的,我也简单的进行记录一下。由于生活中一些问题,最近也是刚开始进行ai写作。然后边接淘宝的单,看chy大佬的帖子在运营咸鱼的账号,个人也有点拖拉,所以写下这篇日记,提升一下自己的执行力,慢慢进步。 最后也希望薪网的小伙伴一起加油。

|  打卡薪网课程

7160 人阅读

|

2 人回复

打卡薪网课程

7160 人阅读

|

2 人回复